telegeram下载安卓官方版

tokenizerbert的简单介绍

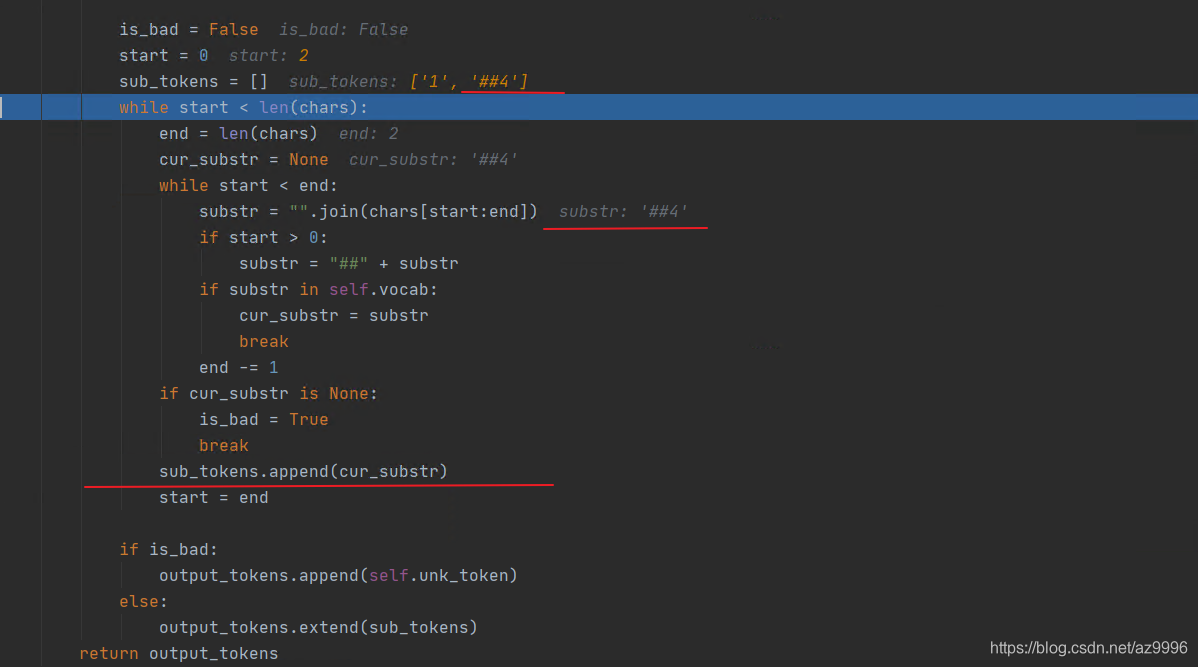

有 BertTokenizerFast 和 BertTokenizer, BertTokenizerFast 更快,因为使用了 tokenizer 库因为 tokenizer 库基于 RUST 所以多线程更好而 BertTokenizer 基于 python 的所以,我们使用 BertTokenizerFast from transformer。

情况是 我用 add_tokens方法 添加自己的新词后,BertTokenizerfrom_pretrainedmodel一直处于加载中原因 有说是词典太大,耗时hours才加载出来我也没有真的等到过暂时的解决办法参考于。

EntitySynonymMapper就像乐团的调音师,处理同义词,确保在用户输入中的变化不会影响到对话的准确理解配置文件中的DIETClassifier则是意图分类的指挥棒,它结合多种特征生成器,如BertTokenizer支持中文分词的rasa_chinese和Ji。

BERT自带的Tokenizer会强行把中文字符用空格隔开,因此就算你把词加入到字典中,也不会分出中文词来此外,BERT做英文word。

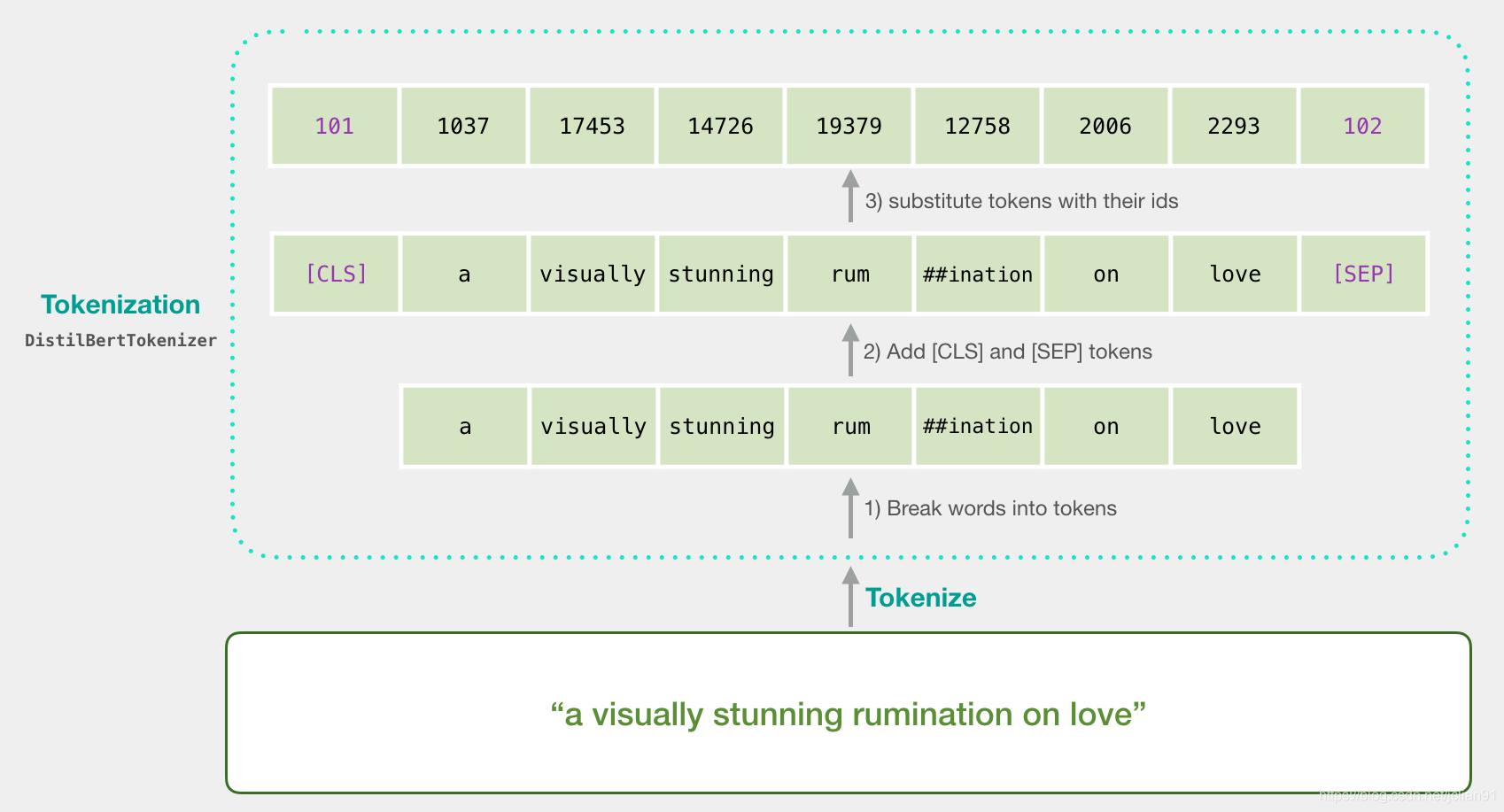

用BERT tokenizer把句子分为两个token第二步,我们加入句子分类用的特殊token第一个位置的是CLS,句子结束的位置是。

bert_tokenizer = BertTokenizerfrom_pretrainedbert_model我们检查一下,看预训练模型都认识哪些字这里我们随意选取从 2000。

tokenizer_class, pretrained_weights = ppbBertModel, ppbBertTokenizer, 'bertbaseuncased'# Load pretrained model。

Bert 的 Tokenizer 并重构一下它from keras_bert import load_trained_model_from_checkpoint, Tokenizerimport codecsconfig_path =。

新词倒是很常见,但是在中文BERT里直接就被tokenizer切成字了,因此一般没有多大的扩充词字表的需要笔者在古汉语语料上。

而且tokenizer并不是真正的bert的tokenizer,中文大部分不会有太大问题,英文的话实际上因为考虑BPE,所以肯定是不行的本项目。